KI lokal: Wieviel RAM braucht ein KI-Modell?

KI lokal: Wieviel RAM braucht ein KI-Modell?

Die Hardware ist vorhanden, die Umgebung ist aufgesetzt. Doch welches Modell von Hugging Face oder der Ollama Model Library passt denn jetzt in meine lokale Welt?

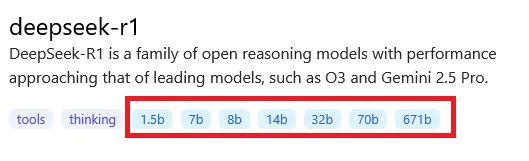

KI-Modelle in der Ollama Model Library oder von Hugging Face geben an, wieviele Parameter sie verwenden – je mehr Parameter, desto leistungsfähiger das Modell, wird angenommen. Mit Hilfe dieser Parameter-Zahl lässt sich abschätzen, welche Speicheranforderungen ein Modell an das eigene System stellt. Die Parameterzahl lässt sich entweder direkt aus dem Namen (z.B. „gpt-oss-20b“) oder aus der Beschreibung des jeweiligen Modells entnehmen – in der Ollama Model Library sind diese Werte direkt verlinkt zu den jeweiligen Modellen:

Die Amerikaner zählen „millions, billions, trillions“, anders als wir Europäer, die „Millionen, Milliarden, Billionen, Billiarden…“ zählen. Ein 2b-Modell hat also 2 Milliarden Parameter.

Ein Parameter entspricht grundsätzlich einer Variablen im Arbeitsspeicher, und da moderne Systeme normalerweise Fließkommzahlen als 32-bit-Werte speichern, entsprechend also 4 Byte je Parameter, sollte sich für ein Modell mit 2 Milliarden Parametern (ein 2b-Modell) ein Speicherplatz von 4 byte x 2 Milliarden = 8 Gigabyte ergeben?

Speicherplatzbedarf optimiert

Fast, aber nicht ganz! Dass der Speicherverbrauch eines Modells ein limitierender Faktor ist, hat auch die Entwicklergemeinde ganz schnell verstanden, und zwei ganz grundsätzliche Gegenmaßnahmen ergriffen:

Erstens reicht es für KI-Systeme meist aus, 16-bit-Fließkomma-Operationen (= 2 Byte) durchzuführen, was den Speicherbedarf gerade mal halbiert! Für nicht-quantisierte Modelle (siehe unten) gilt also folgende Tabelle für 16-bit-Fließkomma-Parameter:

| Modellgröße | Speicherbedarf (ca.) |

|---|---|

| 2b | 4 GB |

| 3b | 6 GB |

| 7b | 14 GB |

| 13b | 26 GB |

Zweitens können KI-Systeme „quantisiert“ werden, d.h. die Entwickler*innen des Modells legen die zu verwendende Bit-Breite selbst fest – und geben dies durch ein q-Suffix im Modellnamen an, z. B. ist „llama2:7b-q4“ – ein 7b-Modell mit 4-bit-Werten (= 0,5 Byte), also:

0,5 byte x 7 Milliarden = 3,5 Gigabyte.

Hierzu gibt es natürlich keine Tabelle, da ist selbst rechnen angesagt, nach folgender Formel:

Bit-Breite in Byte x Anzahl Parameter = RAM-Bedarf des Modells in Byte

In der Praxis können sich höhere Werte als berechnet ergeben, diese Formel liefert lediglich eine Orientierung.

Fazit

Modellname und Beschreibung geben Hinweise auf die Paramterzahl und damit den Speicherplatzbedarf eines Modells. Aktuelle Modelle verwenden 16-Bit-Fließkomma-Operationen, der Speicherplatzbedarf ist also über eine simple Formel bestimmbar. Als Besitzer eines Systems mit 16 GB RAM oder noch besser 16 GB VRAM der GPU kann man also Modelle bis 7 Milliarden Parameter (7b-Modelle) in seinem System verkraften, bei quantisierten Modellen je nach Bit-Breite auch deutlich mehr.